- Alink权威指南:机器学习实例入门(Java版)

- Alink教程(Java版)目录

- Alink教程(Java版)代码的运行攻略

- 下载部分示例数据的Java代码

- Alink教程(Java版)的数据和资料链接

- 第1章 Alink快速上手

- 第1.1节 Alink是什么

- 第1.2节 免费下载、安装

- 第1.2.1节 使用 Maven 快速构建 Alink Java 项目

- 第1.2.2节 在集群上运行 Alink Java 任务

- 第1.3节 Alink的功能

- 第1.4节 关于数据和代码

- 第2章 系统概况与核心概念

- 第2.1节 基本概念

- 第2.2节 批式任务与流式任务

- 第2.3节 Alink=A+link

- 第2.4节 Pipeline与PipelineModel

- 第2.5节 触发Alink任务的执行

- 第2.5.1节 批式任务打印输出中间结果

- 第2.6节 模型信息显示

- 第2.7节 文件系统与数据库

- 第2.8节 Schema String

- 第3章 文件系统与数据文件

- 第3.2.4节 读取Parquet文件格式数据

- 第3.2.5节 定时输出流式数据

- 第3.2.6节 读取分区格式数据

- 第4章 数据库与数据表

- 第4.5节 Alink连接Kafka数据源

- 第5章 支持Flink SQL

- 第5.3.4节 Flink与Alink的数据转换

- 第6章 用户定义函数(UDF/UDTF)

- 第7章 基本数据处理

- 第7.6节 数据列的选择

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第10章 特征的转化

- 第11章 构造新特征

- 第12章 从二分类到多分类

- 第13章 常用多分类算法

- 第14章 在线学习

- 第15章 回归的由来

- 第16章 常用回归算法

- 第17章 常用聚类算法

- 第18章 批式与流式聚类

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第22章 单词向量化

- 第23章 情感分析

- 第23.5节 中文情感分析示例

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 第25.1节 深度学习组件简介

- 第25.1.1节 深度学习功能概览

- 第25.1.2节 KerasSequential组件

- 第25.1.3节 深度学习相关插件的下载

- 第25.2节 手写识别MNIST

- 第25.3节 深度回归算法

- 第25.4节 运行TensorFlow模型

- 第25.5节 运行PyTorch模型

- 第25.6节 使用自定义 TensorFlow 脚本

- 第25.7节 运行ONNX模型

- 第26章 图像识别

- 第26.1节 数据准备

- 第26.2节 构造二分类模型

- 第26.3节 使用TF Hub模型

- 第27章 语音识别

- 第27.1节 数据准备

- 第27.2节 提取MFCC特征

- 第27.3节 情绪识别

- 第27.4节 录音人识别

- 第28章 深度文本分析

- 第28.1节 中文情感分析

- 第28.2节 BERT文本向量化

- 第28.3节 BERT文本分类器

- 第29章 模型流

- 第29.1节 “看到”模型流

- 第29.2节 批式训练与模型流

- 第29.3节 流式预测与LocalPredictor

- 第29.4节 PipelineModel构成的模型流

- 第29.5节 线性模型的增量训练

- 第29.6节 模型流的过滤

- 第30章 多并行与多线程

- 第30.1节 并行度(Parallelism)

- 第30.2节 多线程(Multi-threads)

- 第30.3节 LocalPredictor使用线程池

- 第31章 图嵌入表示GraphEmbedding

- 第31.1节 算法简介

- 第31.2节 示例数据

- 第31.3节 计算Embedding

- 第31.4节 查看Embedding

- 第31.5节 分类示例

- 第31.6节 改变训练参数

- Alink权威指南:机器学习实例入门(Python版)

- Alink教程(Python版)目录

- Alink教程(Python版)代码的运行攻略

- Alink教程(Python版)的数据和资料链接

- 第1章 Alink快速上手

- 第1.1节 Alink是什么

- 第1.2节 免费下载、安装

- 第1.2.1节 PyAlink快速开始

- 第1.2.1.1节 PyAlink安装准备——MacOS

- 第1.2.1.2节 PyAlink安装准备——阿里云服务器

- 第1.2.1.3节 如何安装最新版本PyAlink?

- 第1.2.1.4节 PyAlink的版本查询、卸载旧版本

- 第1.2.2节 在 Flink 集群上运行 PyAlink 任务

- 第1.3节 Alink的功能

- 第1.4节 关于数据和代码

- 第1.5节 简单示例

- 第2章 系统概况与核心概念

- 第2.1节 基本概念

- 第2.2节 批式任务与流式任务

- 第2.3节 Alink=A+link

- 第2.4节 Pipeline与PipelineModel

- 第2.5节 触发Alink任务的执行

- 第2.5.1节 批式任务打印输出中间结果

- 第2.6节 模型信息显示

- 第2.7节 文件系统与数据库

- 第2.8节 Schema String

- 第3章 文件系统与数据文件

- 第3.2.4节 读取Parquet文件格式数据

- 第3.2.5节 定时输出流式数据

- 第3.2.6节 读取分区格式数据

- 第4章 数据库与数据表

- 第4.5节 Alink连接Kafka数据源

- 第5章 支持Flink SQL

- 第5.3.4节 Flink与Alink的数据转换

- 第6章 用户定义函数(UDF/UDTF)

- 第7章 基本数据处理

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第10章 特征的转化

- 第11章 构造新特征

- 第12章 从二分类到多分类

- 第13章 常用的多分类算法

- 第14章 在线学习

- 第15章 回归的由来

- 第16章 常用的回归算法

- 第17章 常用的聚类算法

- 第18章 批式与流式聚类

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第22章 单词向量化

- 第23章 情感分析

- 第23.5节 中文情感分析示例

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 第25.1节 深度学习组件简介

- 第25.1.1节 深度学习功能概览

- 第25.1.2节 KerasSequential组件

- 第25.1.3节 深度学习相关插件的下载

- 第25.2节 手写识别MNIST

- 第25.3节 深度回归算法

- 第25.4节 运行TensorFlow模型

- 第25.5节 运行PyTorch模型

- 第25.6节 使用自定义 TensorFlow 脚本

- 第25.7节 运行ONNX模型

- 第26章 图像识别

- 第26.1节 数据准备

- 第26.2节 构造二分类模型

- 第26.3节 使用TF Hub模型

- 第1章 Alink快速上手

- 在Flink集群部署Alink

- 在易用性方面的小技巧

- 流式组件输出数据的显示(基于Jupyter环境)

- Alink插件下载器

- 第2章 系统概况与核心概念

- Failed to load BLAS警告——Mac OS上解决方法

- 在Linux,Mac下定时执行Alink任务

- 第3章 文件系统与数据文件

- 第4章 数据库与数据表

- Catalog中设置数据库分区【Alink使用技巧】

- 在MacOS上搭建Kafka

- 在Windows上搭建Kafka

- 第5章 支持Flink SQL

- 第7章 基本数据处理

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第11章 构造新特征

- GBDT+LR 一体化模型训练与预测

- GBDT+FM 一体化模型训练及预测

- 第13章 常用的多分类算法

- 第14章 在线学习 Ftrl Demo

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 基于图算法实现金融风控

- 如何使用Alink时间序列算法?

- 如何使用Alink窗口特征生成?

GBDT+FM 一体化模型训练及预测

GBDT+FM 模型是由 Gbdt+LR 延伸出来的模型。该模型利用GBDT自动进行特征筛选和组合,进而生成新的离散特征向量,再把该特征向量当做 FM 模型的输入,来产生最后的预测结果。该模型能够综合利用用户、物品和上下文等多种不同的特征,生成较为全面的推荐,在CTR点击率预估场景下使用较为广泛。

本文将介绍如何使用 Alink 快速的构建 Gbdt+FM 模型,并且会介绍如何方便的将建立的模型部署成服务。

数据准备

Adult 数据来源 https://archive.ics.uci.edu/ml/datasets/Adult

算法相关文档:https://alinklab.cn/manual/csvsourcebatchop.html

Adult数据集(即“人口普查收入”数据集),由美国人口普查数据集库 抽取而来,其中共包含48842条记录,年收入大于50k美元的占比23.93%,年收入小于50k美元的占比76.07%,并且已经划分为训练数据32561条和测试数据16281条。 该数据集类变量为年收入是否超过50k美元,属性变量包括年龄、工种、学历、职业等 14类重要信息,其中有8类属于类别离散型变量,另外6类属于数值连续型变量。该数据集是一个分类数据集,用来预测年收入是否超过50k美元。

PATH = "https://alink-test-data.oss-cn-hangzhou.aliyuncs.com/"

TRAIN_FILE = "adult_train.csv"

TEST_FILE = "adult_test.csv"

SCHEMA_STRING = "age bigint, workclass string, fnlwgt bigint, education string, education_num bigint,"\

+ " marital_status string, occupation string, relationship string, race string, sex string, "\

+ "capital_gain bigint, capital_loss bigint, hours_per_week bigint, native_country string, label string"

trainData = CsvSourceBatchOp() \

.setFilePath(PATH + TRAIN_FILE) \

.setFieldDelimiter(",") \

.setSchemaStr(SCHEMA_STRING)

testData = CsvSourceBatchOp() \

.setFilePath(PATH + TEST_FILE) \

.setFieldDelimiter(",") \

.setSchemaStr(SCHEMA_STRING)

trainData.lazyPrint(5)

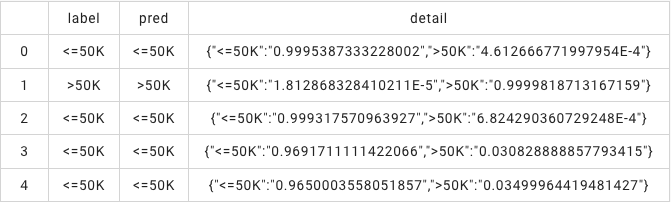

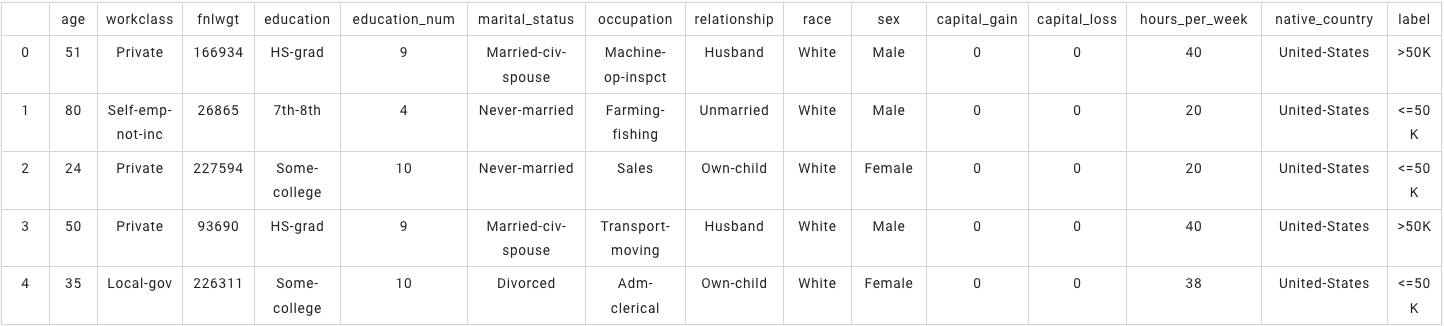

BatchOperator.execute()运行结果为:

训练模型

算法相关文档:

我们通过将 GbdtEncoder 和 FM 这两个算子放到一个Pipeline的方式完成模型的一体化训练。这里是用GbdtEncoder对输入的数据进行编码,并将编码的结果输送给FM进行训练。最终我们得到一个pipeline model,这个模型可以用来对数据进行推理,也可以部署成服务。

featureCols = ["age", "fnlwgt", "education_num", "capital_gain",

"capital_loss", "hours_per_week", "workclass", "education", "marital_status", "occupation",

"relationship", "race", "sex", "native_country"]

numericalCols = ["age", "fnlwgt", "education_num", "capital_gain",

"capital_loss", "hours_per_week"]

label = "label"

vecCol = "vec"

gbdtFmPipe = Pipeline() \

.add(

GbdtEncoder()\

.setLabelCol(label)\

.setFeatureCols(featureCols)\

.setReservedCols([label])\

.setPredictionCol(vecCol))\

.add(

FmClassifier() \

.setVectorCol(vecCol) \

.setLabelCol(label) \

.setReservedCols([label]) \

.setPredictionDetailCol("detail") \

.setPredictionCol("pred"))

model = gbdtFmPipe.fit(trainData)模型评估

算法相关文档:

- https://alinklab.cn/manual/evalbinaryclassbatchop.html

- https://alinklab.cn/manual/jsonvaluebatchop.html

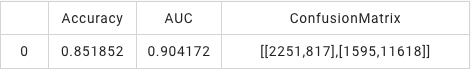

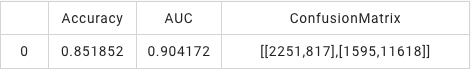

模型评估阶段,我们先试用上面训练好的模型对testData进行推理,然后用评估组件EvalBinaryClassBatchOp对推理结果进行评估,最后使用JsonValueBatchOp组件完成评估结果的抽取。

result = model.transform(testData)

result.lazyPrint(5)

EvalBinaryClassBatchOp() \

.setPredictionDetailCol("detail").setLabelCol(label).linkFrom(result) \

.link(JsonValueBatchOp().setSelectedCol("Data") \

.setReservedCols([]) \

.setOutputCols(["Accuracy", "AUC", "ConfusionMatrix"]) \

.setJsonPath(["$.Accuracy", "$.AUC", "ConfusionMatrix"])).print()运行结果为:

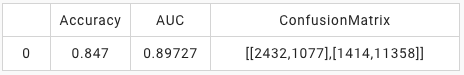

与 Gbdt+LR 效果对比

参考通过对比可以看到,Gbdt+FM 的效果要比 Gbdt+LR 好一些,对于同一个数据,AUC 大概高0.7个百分点。

gbdtLrPipe = Pipeline() \

.add(

GbdtEncoder()\

.setLabelCol(label)\

.setFeatureCols(featureCols)\

.setReservedCols([label])\

.setPredictionCol(vecCol))\

.add(

LogisticRegression() \

.setVectorCol(vecCol) \

.setLabelCol(label) \

.setReservedCols([label]) \

.setPredictionDetailCol("detail") \

.setPredictionCol("pred"))

lrModel = gbdtLrPipe.fit(trainData)

resultLr = lrModel.transform(testData)

resultFm = model.transform(testData)

EvalBinaryClassBatchOp() \

.setPredictionDetailCol("detail").setLabelCol(label).linkFrom(resultLr) \

.link(JsonValueBatchOp().setSelectedCol("Data") \

.setReservedCols([]) \

.setOutputCols(["Accuracy", "AUC", "ConfusionMatrix"]) \

.setJsonPath(["$.Accuracy", "$.AUC", "ConfusionMatrix"])).print()

EvalBinaryClassBatchOp() \

.setPredictionDetailCol("detail").setLabelCol(label).linkFrom(resultFm) \

.link(JsonValueBatchOp().setSelectedCol("Data") \

.setReservedCols([]) \

.setOutputCols(["Accuracy", "AUC", "ConfusionMatrix"]) \

.setJsonPath(["$.Accuracy", "$.AUC", "ConfusionMatrix"])).print()

模型写出

算法相关文档:

模型写出阶段,我们使用AkSinkBatchOp将模型写出到文件系统,这里的文件系统可以是本地文件系统(如代码所示),也可以时网络文件系统(比如OSS),可以通过代码:

fs = OssFileSystem("3.4.1", "oss-cn-hangzhou-zmf.aliyuncs.com", "name", "************", "**********")

filePath = FilePath("/model/gbdt_fm_model.ak", fs)完成网络文件系统路径的构建,将这个路径以参数的方式塞给AkSinkBatchOp组件:

AkSinkBatchOp().setFilePath(filePath).setOverwriteSink(True)

便可以完成将模型写出待网络文件系统的目的。

modelData = model.save();

filePath = "/tmp/gbdt_fm_model.ak"

# 可以将模型文件写出到OSS,这样可以直接部署到EAS,需要一个OSS的idkey。此处直接写出到/tmp 目录下

# fs = OssFileSystem("3.4.1", "oss-cn-hangzhou-zmf.aliyuncs.com", "name", "************", "**********")

# filePath = FilePath("/model/gbdt_fm_model.ak", fs)

modelData.link(AkSinkBatchOp().setFilePath(filePath).setOverwriteSink(True));

BatchOperator.execute();加载模型并推理

这里加载模型的路径和模型写出时一样,可以是本地文件系统(如代码所示),也可以时网络文件系统(比如OSS)。

model = PipelineModel.load(filePath) result = model.transform(testData).lazyPrint(5) BatchOperator.execute()

运行结果为: