- Alink权威指南:机器学习实例入门(Python版)

- Alink教程(Python版)目录

- Alink教程(Python版)代码的运行攻略

- Alink教程(Python版)的数据和资料链接

- 第1章 Alink快速上手

- 第1.1节 Alink是什么

- 第1.2节 免费下载、安装

- 第1.2.1节 PyAlink快速开始

- 第1.2.1.1节 PyAlink安装准备——MacOS

- 第1.2.1.2节 PyAlink安装准备——阿里云服务器

- 第1.2.1.3节 如何安装最新版本PyAlink?

- 第1.2.1.4节 PyAlink的版本查询、卸载旧版本

- 第1.2.2节 在 Flink 集群上运行 PyAlink 任务

- 第1.3节 Alink的功能

- 第1.4节 关于数据和代码

- 第1.5节 简单示例

- 第2章 系统概况与核心概念

- 第2.1节 基本概念

- 第2.2节 批式任务与流式任务

- 第2.3节 Alink=A+link

- 第2.4节 Pipeline与PipelineModel

- 第2.5节 触发Alink任务的执行

- 第2.5.1节 批式任务打印输出中间结果

- 第2.6节 模型信息显示

- 第2.7节 文件系统与数据库

- 第2.8节 Schema String

- 第3章 文件系统与数据文件

- 第3.2.4节 读取Parquet文件格式数据

- 第3.2.5节 定时输出流式数据

- 第3.2.6节 读取分区格式数据

- 第4章 数据库与数据表

- 第4.5节 Alink连接Kafka数据源

- 第5章 支持Flink SQL

- 第5.3.4节 Flink与Alink的数据转换

- 第6章 用户定义函数(UDF/UDTF)

- 第7章 基本数据处理

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第10章 特征的转化

- 第11章 构造新特征

- 第12章 从二分类到多分类

- 第13章 常用的多分类算法

- 第14章 在线学习

- 第15章 回归的由来

- 第16章 常用的回归算法

- 第17章 常用的聚类算法

- 第18章 批式与流式聚类

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第22章 单词向量化

- 第23章 情感分析

- 第23.5节 中文情感分析示例

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 第25.1节 深度学习组件简介

- 第25.1.1节 深度学习功能概览

- 第25.1.2节 KerasSequential组件

- 第25.1.3节 深度学习相关插件的下载

- 第25.2节 手写识别MNIST

- 第25.3节 深度回归算法

- 第25.4节 运行TensorFlow模型

- 第25.5节 运行PyTorch模型

- 第25.6节 使用自定义 TensorFlow 脚本

- 第25.7节 运行ONNX模型

- 第26章 图像识别

- 第26.1节 数据准备

- 第26.2节 构造二分类模型

- 第26.3节 使用TF Hub模型

- 第1章 Alink快速上手

- 在Flink集群部署Alink

- 在易用性方面的小技巧

- 流式组件输出数据的显示(基于Jupyter环境)

- Alink插件下载器

- 第2章 系统概况与核心概念

- Failed to load BLAS警告——Mac OS上解决方法

- 在Linux,Mac下定时执行Alink任务

- Failed to load BLAS警告——Linux上解决方法

- 第3章 文件系统与数据文件

- 第4章 数据库与数据表

- Catalog中设置数据库分区【Alink使用技巧】

- 在MacOS上搭建Kafka

- 在Windows上搭建Kafka

- 第5章 支持Flink SQL

- 第7章 基本数据处理

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第11章 构造新特征

- GBDT+LR 一体化模型训练与预测

- GBDT+FM 一体化模型训练及预测

- 第13章 常用的多分类算法

- 第14章 在线学习 Ftrl Demo

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 基于图算法实现金融风控

- 如何使用Alink时间序列算法?

- 如何使用Alink窗口特征生成?

第25.7节 运行ONNX模型

ONNX(Open Neural Network Exchange,开放神经网络交换)是为人工智能模型(深度学习和传统ML)提供的一种开放格式,可使模型在不同框架之间进行转移。详见 https://github.com/onnx/onnx

Alink提供了OnnxModelPredictBatchOp、OnnxModelPredictStreamOp和�OnnxModelPredictor组件,分别处理批式场景、流式场景和进行Pipeline封装。

��

各组件都需要指定 ONNX 模型的modelPath模型路径参数。模型路径可以是以下形式:

- 本地文件:

file://加绝对路径,例如file:///tmp/dnn.py; - Java 包中的资源文件:

res://加路径,例如res:///dnn.py; - http/https 文件:

http://或https://路径; - OSS 文件:

oss://加路径和 Endpoint 和 access key

等信息,例如oss://bucket/xxx/xxx/xxx.py?host=xxx&access_key_id=xxx&access_key_secret=xxx; - HDFS 文件:

hdfs://加路径;

参与模型预测的数据通过参数 selectedCols 设置,需要注意以下几点:

- ONNX 模型使用 input name 来标识模型输入桩的,因此需要设置

inputNames,与selectedCols一一对应,表明某列对应某输入桩。inputNames不填写时,默认与列名一致。 - 仅支持输入桩为

Tensor类型,不支持Sequences和Maps类型。 - 所选择的列的类型需要是

float, double, int, long, byte, string类型及其对应的 AlinkTensor类型。

模型输出信息通过参数 outputSchemaStr 指定,包括输出列名以及名称,需要注意以下几点:

- ONNX 模型使用 output name 来标识模型输出桩的,因此需要设置

outputNames,与outputSchemaStr一一对应,表明某列对应某输入桩。outputNames不填写时,默认与列名一致。 - 仅支持输出桩为

Tensor类型,不支持Sequences和Maps类型。 outputSchemaStr填写的输出类型需要是对应的输出桩类型,例如 输出桩类型 为 Float 类型的 Tensor 时,对应的 Alink 类型可以是TENSOR或者FLOAT_TENSOR,当输出仅包含一个元素时,还可以是FLOAT。

组件使用的是 ONNX 1.11.0 版本,当有 GPU 时,自动使用 GPU 进行推理,否则使用 CPU 进行推理。

25.7.1 批式任务中使用ONNX模型

使用OnnxModelPredictBatchOp组件,可以加载ONNX模型进行批式预测。关于该组件的详细说明参见Alink文档 https://www.yuque.com/pinshu/alink_doc/onnxmodelpredictbatchop .

使用ONNX模型前,还需要将输入数据列的类型转换为Tensor格式,可以使用VectorToTensorBatchOp组件。具体代码如下所示:

AkSourceBatchOp()\

.setFilePath(Chap13_DATA_DIR + Chap13_DENSE_TEST_FILE)\

.link(

VectorToTensorBatchOp()\

.setTensorDataType("float")\

.setTensorShape([1, 1, 28, 28])\

.setSelectedCol("vec")\

.setOutputCol("tensor")\

.setReservedCols(["label"])

)\

.link(

OnnxModelPredictBatchOp()\

.setModelPath(

"https://alink-release.oss-cn-beijing.aliyuncs.com/data-files/cnn_mnist_pytorch.onnx")\

.setSelectedCols(["tensor"])\

.setInputNames(["0"])\

.setOutputNames(["21"])\

.setOutputSchemaStr("probabilities FLOAT_TENSOR")

)\

.link(

UDFBatchOp()\

.setFunc(get_max_index)\

.setSelectedCols(["probabilities"])\

.setOutputCol("pred")

)\

.lazyPrint(3)\

.link(

EvalMultiClassBatchOp()\

.setLabelCol("label")\

.setPredictionCol("pred")\

.lazyPrintMetrics()

)

BatchOperator.execute()这里用到了一个自定义函数,具体定义如下:

import numpy as np

@udf(input_types=[AlinkDataTypes.TENSOR()], result_type=AlinkDataTypes.INT())

def get_max_index(tensor: np.ndarray):

return tensor.argmax().item()

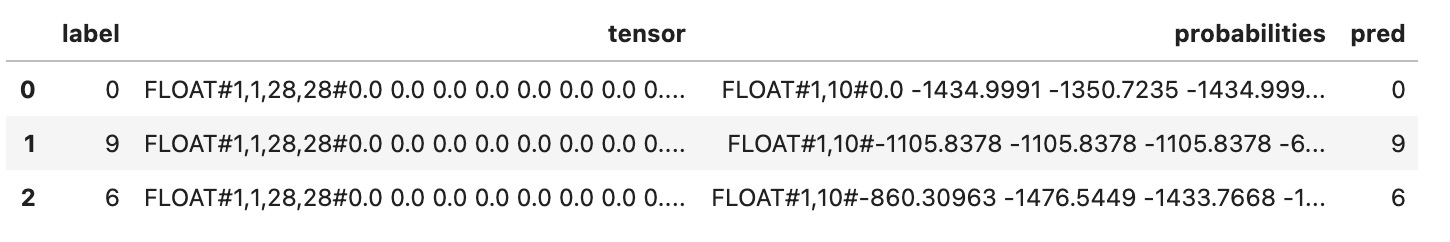

批式任务的运行结果为:

-------------------------------- Metrics: -------------------------------- Accuracy:0.9904 Macro F1:0.9904 Micro F1:0.9904 Kappa:0.9893 |Pred\Real| 9| 8| 7|...| 2| 1| 0| |---------|---|---|----|---|----|----|---| | 9|988| 3| 3|...| 0| 0| 0| | 8| 1|962| 0|...| 1| 0| 1| | 7| 6| 2|1014|...| 3| 0| 1| | ...|...|...| ...|...| ...| ...|...| | 2| 0| 2| 3|...|1021| 0| 0| | 1| 3| 0| 6|...| 3|1134| 0| | 0| 2| 4| 0|...| 1| 0|978|

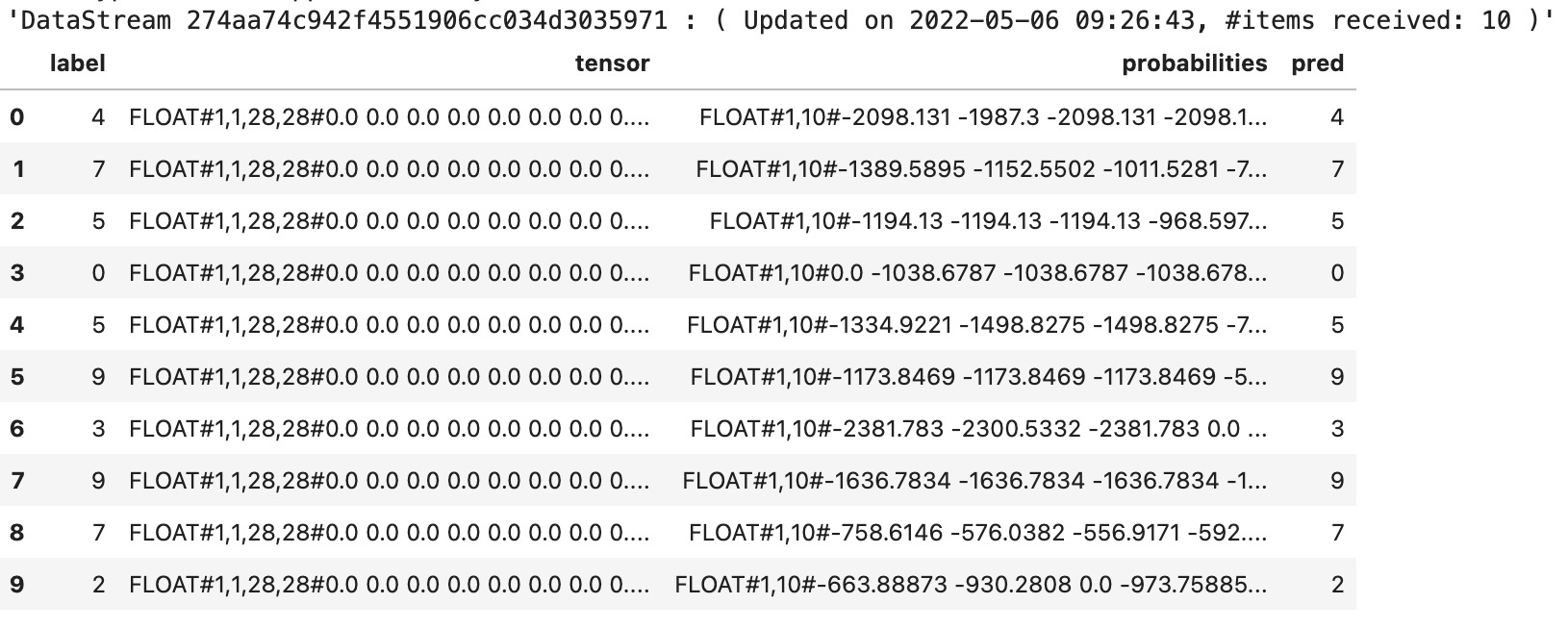

25.7.2 流式任务中使用ONNX模型

使用OnnxModelPredictStreamOp组件,可以加载ONNX模型进行批式预测。关于该组件的详细说明参见Alink文档 https://www.yuque.com/pinshu/alink_doc/onnxmodelpredictstreamop .

使用ONNX模型前,还需要将输入数据列的类型转换为Tensor格式,可以使用VectorToTensorStreamOp组件。具体代码如下所示:

AkSourceStreamOp()\

.setFilePath(Chap13_DATA_DIR + Chap13_DENSE_TEST_FILE)\

.link(

VectorToTensorStreamOp()\

.setTensorDataType("float")\

.setTensorShape([1, 1, 28, 28])\

.setSelectedCol("vec")\

.setOutputCol("tensor")\

.setReservedCols(["label"])

)\

.link(

OnnxModelPredictStreamOp()\

.setModelPath("https://alink-release.oss-cn-beijing.aliyuncs.com/data-files/cnn_mnist_pytorch.onnx")\

.setSelectedCols(["tensor"])\

.setInputNames(["0"])\

.setOutputNames(["21"])\

.setOutputSchemaStr("probabilities FLOAT_TENSOR")

)\

.link(

UDFStreamOp()\

.setFunc(get_max_index)\

.setSelectedCols(["probabilities"])\

.setOutputCol("pred")

)\

.sample(0.001)\

.print()

StreamOperator.execute()运行结果为:

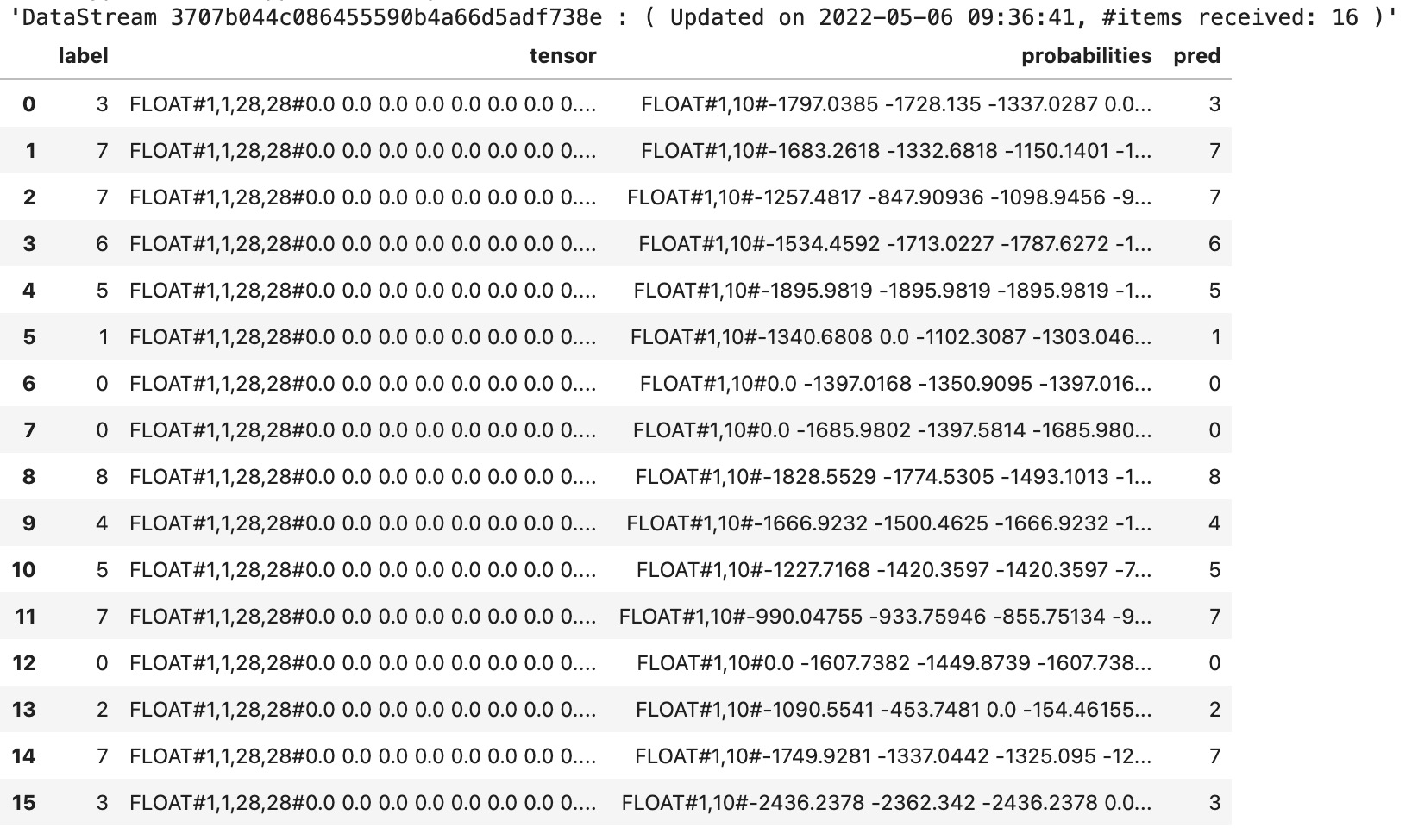

25.7.3 Pipeline中使用ONNX模型

学习了如何在批式任务和流式任务中使用ONNX模型,我们很容易在Pipeline中使用ONNX模型进行预测,只要将其中的批式/流式组件对应到Pipeline组件即可。具体代码如下:

PipelineModel(

VectorToTensor()\

.setTensorDataType("float")\

.setTensorShape([1, 1, 28, 28])\

.setSelectedCol("vec")\

.setOutputCol("tensor")\

.setReservedCols(["label"]),

OnnxModelPredictor()\

.setModelPath("https://alink-release.oss-cn-beijing.aliyuncs.com/data-files/cnn_mnist_pytorch.onnx")\

.setSelectedCols(["tensor"])\

.setInputNames(["0"])\

.setOutputNames(["21"])\

.setOutputSchemaStr("probabilities FLOAT_TENSOR")

).save(Chap13_DATA_DIR + PIPELINE_ONNX_MODEL, True)

BatchOperator.execute()

PipelineModel\

.load(Chap13_DATA_DIR + PIPELINE_ONNX_MODEL)\

.transform(

AkSourceStreamOp()\

.setFilePath(Chap13_DATA_DIR + Chap13_DENSE_TEST_FILE)

)\

.link(

UDFStreamOp()\

.setFunc(get_max_index)\

.setSelectedCols(["probabilities"])\

.setOutputCol("pred")

)\

.sample(0.001)\

.print()

StreamOperator.execute()运行结果为:

25.7.4 LocalPredictor中使用ONNX模型

除了通过Alink任务使用ONNX模型,也可以使用LocalPredictor进行嵌入式预测。示例代码如下,首先从数据集中抽取一行数据,输入数据的SchemaStr为“vec string, label int”;然后通过导入上一节保存的Pipeline模型,并设置输入数据的SchemaStr,得到LocalPredictor类型的实例localPredictor;如果不确定预测结果各列的含义,可以打印输出localPredictor的OutputSchema;使用localPredictor的map方法获得预测结果。

source = AkSourceBatchOp().setFilePath(Chap13_DATA_DIR + Chap13_DENSE_TEST_FILE) print(source.getSchemaStr()) df = source.firstN(1).collectToDataframe() row = [df.iat[0,0], df.iat[0,1].item()] localPredictor = LocalPredictor(Chap13_DATA_DIR + PIPELINE_ONNX_MODEL, "vec string, label int") print(localPredictor.getOutputSchemaStr()) r = localPredictor.map(row) print(str(r[0]) + " | " + str(r[2]))

运行结果为:

vec VARCHAR, label INT label INT, tensor ANY<com.alibaba.alink.common.linalg.tensor.FloatTensor>, probabilities ANY<com.alibaba.alink.common.linalg.tensor.FloatTensor> 2 | FloatTensor(1,10) [[-1397.7644 -999.7633 0.0 ... -1533.649 -1142.1455 -1608.5127]]