Alink教程(Java版)

- Alink权威指南:机器学习实例入门(Java版)

- Alink教程(Java版)目录

- Alink教程(Java版)代码的运行攻略

- 下载部分示例数据的Java代码

- Alink教程(Java版)的数据和资料链接

- 第1章 Alink快速上手

- 第1.1节 Alink是什么

- 第1.2节 免费下载、安装

- 第1.2.1节 使用 Maven 快速构建 Alink Java 项目

- 第1.2.2节 在集群上运行 Alink Java 任务

- 第1.3节 Alink的功能

- 第1.4节 关于数据和代码

- 第2章 系统概况与核心概念

- 第2.1节 基本概念

- 第2.2节 批式任务与流式任务

- 第2.3节 Alink=A+link

- 第2.4节 Pipeline与PipelineModel

- 第2.5节 触发Alink任务的执行

- 第2.5.1节 批式任务打印输出中间结果

- 第2.6节 模型信息显示

- 第2.7节 文件系统与数据库

- 第2.8节 Schema String

- 第3章 文件系统与数据文件

- 第3.2.4节 读取Parquet文件格式数据

- 第3.2.5节 定时输出流式数据

- 第3.2.6节 读取分区格式数据

- 第4章 数据库与数据表

- 第4.5节 Alink连接Kafka数据源

- 第5章 支持Flink SQL

- 第5.3.4节 Flink与Alink的数据转换

- 第6章 用户定义函数(UDF/UDTF)

- 第7章 基本数据处理

- 第7.6节 数据列的选择

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第10章 特征的转化

- 第11章 构造新特征

- 第12章 从二分类到多分类

- 第13章 常用多分类算法

- 第14章 在线学习

- 第15章 回归的由来

- 第16章 常用回归算法

- 第17章 常用聚类算法

- 第18章 批式与流式聚类

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第22章 单词向量化

- 第23章 情感分析

- 第23.5节 中文情感分析示例

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 第25.1节 深度学习组件简介

- 第25.1.1节 深度学习功能概览

- 第25.1.2节 KerasSequential组件

- 第25.1.3节 深度学习相关插件的下载

- 第25.2节 手写识别MNIST

- 第25.3节 深度回归算法

- 第25.4节 运行TensorFlow模型

- 第25.5节 运行PyTorch模型

- 第25.6节 使用自定义 TensorFlow 脚本

- 第25.7节 运行ONNX模型

- 第26章 图像识别

- 第26.1节 数据准备

- 第26.2节 构造二分类模型

- 第26.3节 使用TF Hub模型

- 第27章 语音识别

- 第27.1节 数据准备

- 第27.2节 提取MFCC特征

- 第27.3节 情绪识别

- 第27.4节 录音人识别

- 第28章 深度文本分析

- 第28.1节 中文情感分析

- 第28.2节 BERT文本向量化

- 第28.3节 BERT文本分类器

- 第29章 模型流

- 第29.1节 “看到”模型流

- 第29.2节 批式训练与模型流

- 第29.3节 流式预测与LocalPredictor

- 第29.4节 PipelineModel构成的模型流

- 第29.5节 线性模型的增量训练

- 第29.6节 模型流的过滤

- 第30章 多并行与多线程

- 第30.1节 并行度(Parallelism)

- 第30.2节 多线程(Multi-threads)

- 第30.3节 LocalPredictor使用线程池

- 第31章 图嵌入表示GraphEmbedding

- 第31.1节 算法简介

- 第31.2节 示例数据

- 第31.3节 计算Embedding

- 第31.4节 查看Embedding

- 第31.5节 分类示例

- 第31.6节 改变训练参数

教程内容补充、答疑及勘误

- 第1章 Alink快速上手

- 在Flink集群部署Alink

- 在易用性方面的小技巧

- 流式组件输出数据的显示(基于Jupyter环境)

- Alink插件下载器

- 第2章 系统概况与核心概念

- Failed to load BLAS警告——Mac OS上解决方法

- 在Linux,Mac下定时执行Alink任务

- Failed to load BLAS警告——Linux上解决方法

- 第3章 文件系统与数据文件

- 第4章 数据库与数据表

- Catalog中设置数据库分区【Alink使用技巧】

- 在MacOS上搭建Kafka

- 在Windows上搭建Kafka

- 第5章 支持Flink SQL

- 第7章 基本数据处理

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第11章 构造新特征

- GBDT+LR 一体化模型训练与预测

- GBDT+FM 一体化模型训练及预测

- 第13章 常用的多分类算法

- 第14章 在线学习 Ftrl Demo

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 基于图算法实现金融风控

- 如何使用Alink时间序列算法?

- 如何使用Alink窗口特征生成?

第25.1.1节 深度学习功能概览

Alink深度学习相关功能的架构图如下,

整体上分为2层:

- 多层次的组件体系。

- 支持运行TensorFlow脚本

- 支持TF SavedModel的推理

- 支持Keras Sequential模型,使用Keras语法,简捷描述大多数深度模型

- 支持使用TF Hub上的预计算模型

- 支持文本领域广泛使用的BERT算法

- 支持时序算法DeepAR、LSTNet

- 可以结合Alink丰富的特征工程、数据预处理组件,快速搭建应用

- 对应的深度推理组件使用TF Java API 推理,可以同其它Alink推理组件一起进行部署

- “敏捷化”的底层机制

- 借助开源 flink-ai-extended 的能力,在其基础上做出了大量改进和建设

- 在不增加额外的外部依赖的前提下,在同集群、同存储、同处理的条件下,提供深度学习的能力。

- 不依赖外部服务。 仅使用 Flink 自身机制,不依赖zookeeper

- 不依赖外部存储。支持模型(流)写回Java 端做后续处理、导出、推理,形成闭环

我们换个角度,聚焦深度组件的功能体系。

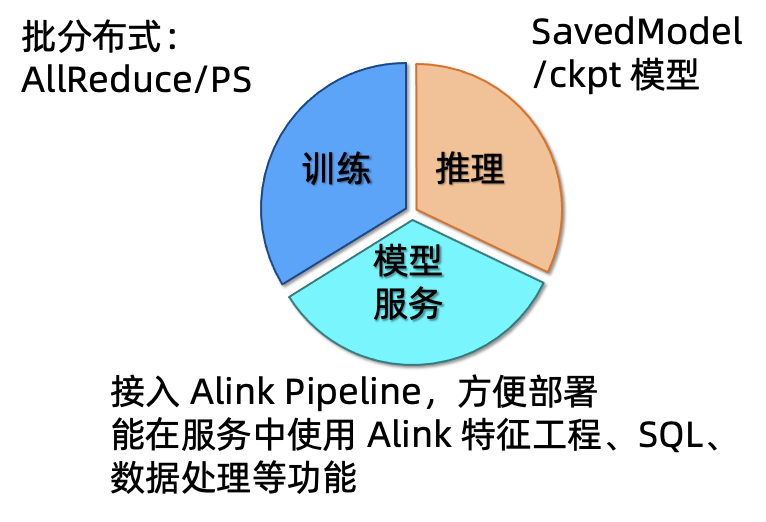

(一)横向功能:提供深度学习基础功能 + Alink 增强

从功能角度可划分为三个部分,如下图所示

- 训练。支持在本地以单进程方式进行训练;支持批式组件的分布式训练,可以选择使用AllReduce或者ParamServer数据通讯模式。

- 推理。使用了TF Java API,可以加载SavedModel或者CheckPoint模型进行推理。

- 模型服务。接入 Alink Pipeline,方便部署;能在服务中使用 Alink 特征工程、SQL、数据处理等功能。

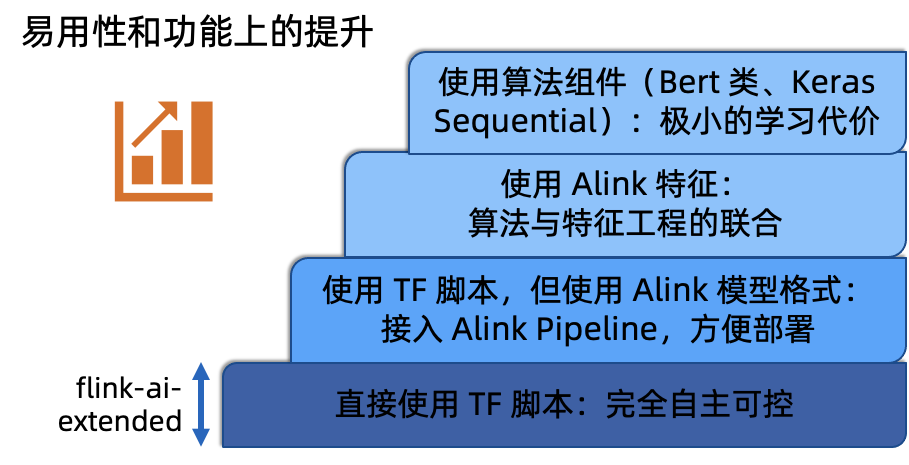

(二)纵向使用:提供多层次的组件抽象,满足不同用户的需要

从使用角度可以划分为四层,如下图所示

- 最底层。适合熟悉TF的用户,直接使用TF脚本,对组件的输出没有限制。

- 第二层。用户还是使用TF脚本,但要求输出TF Saved Model,Alink组件会将原生模型包装为Alink模型格式,从而可以接入Alink Pipeline,方便部署。另外该层组件产生的模型都可以使用TF Java API 进行推理,避免 Java/Python 数据交换带来的延迟;能与PipelineModel中的其它组件一同部署,不需要额外的部署服务

- 第三层。有些深度学习算法中涉及到大量的特征工程,在推荐类算法中尤为常见。将Alink 特征工程与深度模型相结合形成的组件,可以给用户更便捷的使用体验。这一层算法后面会陆续开源。

- 最高层。组件的包装程度较高,完全不需要TensorFlow的编程经验。譬如,BERT算法在使用接口上与其它的分类组件无异;DeepAR/LSTNet在使用方式上与其它的时序组件一致;KerasSequential组件,使用的Keras语法,简单易懂。