- Alink权威指南:机器学习实例入门(Java版)

- Alink教程(Java版)目录

- Alink教程(Java版)代码的运行攻略

- 下载部分示例数据的Java代码

- Alink教程(Java版)的数据和资料链接

- 第1章 Alink快速上手

- 第1.1节 Alink是什么

- 第1.2节 免费下载、安装

- 第1.2.1节 使用 Maven 快速构建 Alink Java 项目

- 第1.2.2节 在集群上运行 Alink Java 任务

- 第1.3节 Alink的功能

- 第1.4节 关于数据和代码

- 第2章 系统概况与核心概念

- 第2.1节 基本概念

- 第2.2节 批式任务与流式任务

- 第2.3节 Alink=A+link

- 第2.4节 Pipeline与PipelineModel

- 第2.5节 触发Alink任务的执行

- 第2.5.1节 批式任务打印输出中间结果

- 第2.6节 模型信息显示

- 第2.7节 文件系统与数据库

- 第2.8节 Schema String

- 第3章 文件系统与数据文件

- 第3.2.4节 读取Parquet文件格式数据

- 第3.2.5节 定时输出流式数据

- 第3.2.6节 读取分区格式数据

- 第4章 数据库与数据表

- 第4.5节 Alink连接Kafka数据源

- 第5章 支持Flink SQL

- 第5.3.4节 Flink与Alink的数据转换

- 第6章 用户定义函数(UDF/UDTF)

- 第7章 基本数据处理

- 第7.6节 数据列的选择

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第10章 特征的转化

- 第11章 构造新特征

- 第12章 从二分类到多分类

- 第13章 常用多分类算法

- 第14章 在线学习

- 第15章 回归的由来

- 第16章 常用回归算法

- 第17章 常用聚类算法

- 第18章 批式与流式聚类

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第22章 单词向量化

- 第23章 情感分析

- 第23.5节 中文情感分析示例

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 第25.1节 深度学习组件简介

- 第25.1.1节 深度学习功能概览

- 第25.1.2节 KerasSequential组件

- 第25.1.3节 深度学习相关插件的下载

- 第25.2节 手写识别MNIST

- 第25.3节 深度回归算法

- 第25.4节 运行TensorFlow模型

- 第25.5节 运行PyTorch模型

- 第25.6节 使用自定义 TensorFlow 脚本

- 第25.7节 运行ONNX模型

- 第26章 图像识别

- 第26.1节 数据准备

- 第26.2节 构造二分类模型

- 第26.3节 使用TF Hub模型

- 第27章 语音识别

- 第27.1节 数据准备

- 第27.2节 提取MFCC特征

- 第27.3节 情绪识别

- 第27.4节 录音人识别

- 第28章 深度文本分析

- 第28.1节 中文情感分析

- 第28.2节 BERT文本向量化

- 第28.3节 BERT文本分类器

- 第29章 模型流

- 第29.1节 “看到”模型流

- 第29.2节 批式训练与模型流

- 第29.3节 流式预测与LocalPredictor

- 第29.4节 PipelineModel构成的模型流

- 第29.5节 线性模型的增量训练

- 第29.6节 模型流的过滤

- 第30章 多并行与多线程

- 第30.1节 并行度(Parallelism)

- 第30.2节 多线程(Multi-threads)

- 第30.3节 LocalPredictor使用线程池

- 第31章 图嵌入表示GraphEmbedding

- 第31.1节 算法简介

- 第31.2节 示例数据

- 第31.3节 计算Embedding

- 第31.4节 查看Embedding

- 第31.5节 分类示例

- 第31.6节 改变训练参数

- 第1章 Alink快速上手

- 在Flink集群部署Alink

- 在易用性方面的小技巧

- 流式组件输出数据的显示(基于Jupyter环境)

- Alink插件下载器

- 第2章 系统概况与核心概念

- Failed to load BLAS警告——Mac OS上解决方法

- 在Linux,Mac下定时执行Alink任务

- Failed to load BLAS警告——Linux上解决方法

- 第3章 文件系统与数据文件

- 第4章 数据库与数据表

- Catalog中设置数据库分区【Alink使用技巧】

- 在MacOS上搭建Kafka

- 在Windows上搭建Kafka

- 第5章 支持Flink SQL

- 第7章 基本数据处理

- 第8章 线性二分类模型

- 第9章 朴素贝叶斯模型与决策树模型

- 第11章 构造新特征

- GBDT+LR 一体化模型训练与预测

- GBDT+FM 一体化模型训练及预测

- 第13章 常用的多分类算法

- 第14章 在线学习 Ftrl Demo

- 第19章 主成分分析

- 第20章 超参数搜索

- 第21章 文本分析

- 第24章 构建推荐系统

- 第25章 深度学习入门

- 基于图算法实现金融风控

- 如何使用Alink时间序列算法?

- 如何使用Alink窗口特征生成?

第31.1节 算法简介

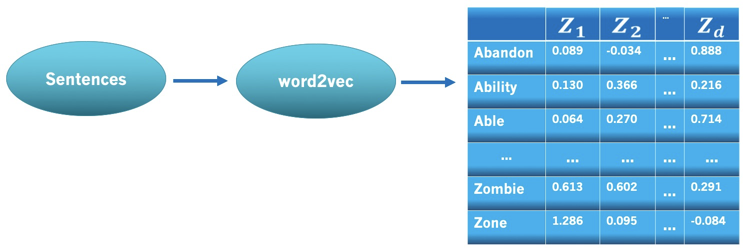

前面介绍过Word2Vec算法,训练集为若干句子,计算出各单词的向量。如图所示。

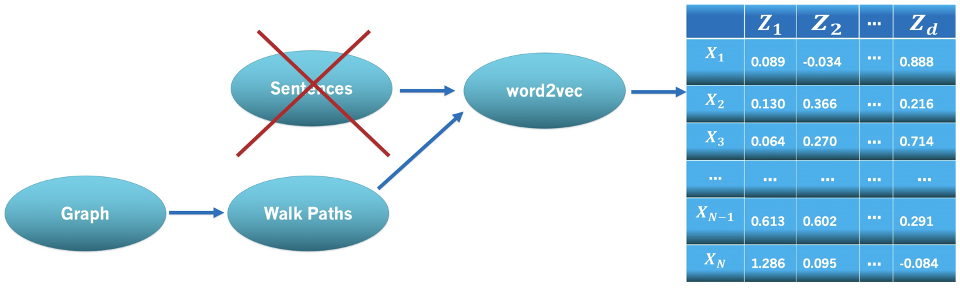

Graph Embedding的计算也借鉴了这种做法,只不过多了一步从图到游走路径集的变换。若将每个图节点看作一个单词,则每条游走路径就相当于一个句子;对游走路径集使用Word2Vec计算,就可得到每个图节点的向量。如图所示:

每个游走方法就对应了一个GraphEmbedding算法,Random Walk(随机游走)对应着DeepWalk算法;Node2Vec Walk对应着Node2Vec算法;Meta Path Walk对应着MetaPath2Vec算法。即

- DeepWalk = Random Walk + Word2Vec

- Node2Vec = Node2Vec Walk + Word2Vec

- MetaPath2Vec = Meta Path Walk + Word2Vec

50.1.1 Random Walk(随机游走)

DeepWalk使用的Random Walk(随机游走),每一步都是当前节点的一个邻居。假设当前随机行走到

这里

进一步,对于加权图,下一个访问节点的选择是通过当前节点加权随机抽取的,计算概率公式如下:

其中

50.1.2 Node2Vec Walk

节点选择上有两种“极端”策略:广度优先(BFS)和深度优先(DFS)。前者仅限于源节点的近邻,而后者则由距离不断增加的连续节点组成。Node2Vec Walk通过引入两个参数

先定义函数

其中

通过

进而得到节点

这里

由公式可以清晰看到Node2Vec Walk需要考虑当前节点

50.1.3 Meta Path Walk

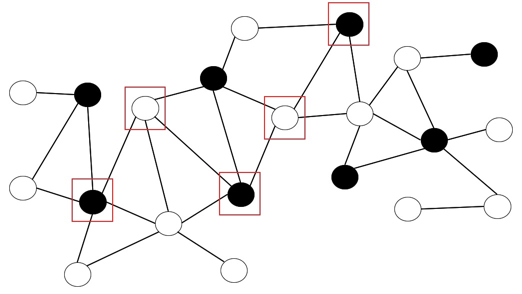

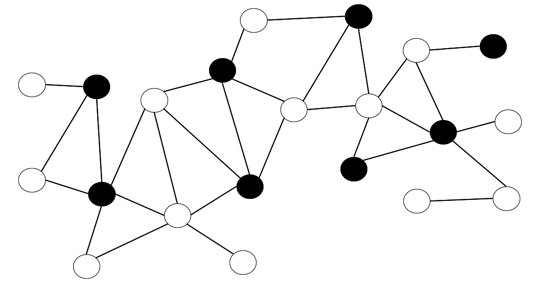

对于Meta Path Walk,主要是在节点上引入了类型信息,在构造游走路径时,节点的类型要满足一定模式。譬如,如下所示,图有两种类型的节点,分别用黑色和白色表示。

我们定义游走路径的模式为黑白相间,路径模版定义为

则根据此模版,产生的一条路径如下,路径选中节点用方框标识。